1.1 为什么要在本地部署DeepSeek

在本地搭建大模型(如DeepSeek)具有多个重要的优势,比如:

- 保护隐私与数据安全。数据不外传:本地运行模型可以完全避免数据上

传至云端,确保敏感信息不被第三方访问。 - 可定制化与优化。支持微调(Fine-tuning):可以根据特定业务需求对模

型进行微调,以适应特定任务,如行业术语、企业内部知识库等。 - 离线运行,适用于无网络环境。可在离线环境下运行:适用于无互联网

连接或网络受限的场景。提高系统稳定性:即使云服务宕机,本地大模型依

然可以正常工作,不受外部因素影响。

1.2 DeepSeek 本地部署三个步骤

一共只需要三步,就能做到DeepSeek 在本地运行并与它对话。

- 第一步,下载并安装ollama

Ollama:是一个人工智能和机器学习工具平台,主要用于在本地电脑运行大型语言模型(LLM),能自动识别并利用 Windows 系统中的最优硬件资源,支持接入完整的 ollama 模型库,提供多种模型用于文本分析等 AI 任务,还设有常驻 API 以便将 AI 功能整合到其他应用中。

使用ollama 管理各种不同大模型,ollama 比较直接、干净,一键下载后安装就行,安装过程基本都是下一步。

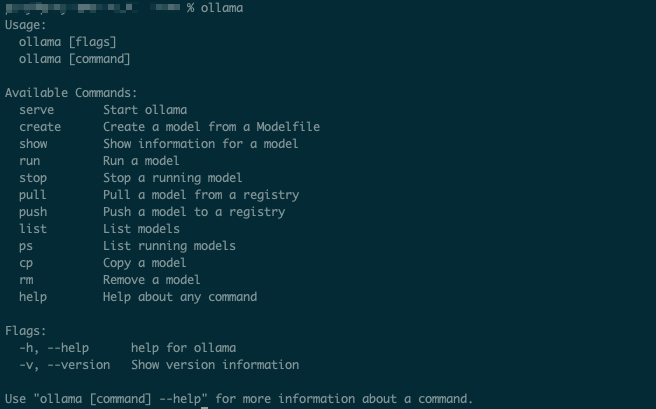

安装后,打开命令窗口,输入ollama,然后就能看到它的相关指令,如下图所示:

- 第二步,下载模型

命令窗口输入:ollama pull deepseek-r1:1.5b,下载大模型deepseek-r1

至此DeepSeek大模型就下载到我们本地电脑

ollama支持的模型可以从此页面进行查看 第三步,运行大模型

在cmd(Windows) 或terminal(Mac) 执行命令:ollama run deepseek-r1:1.5b,很快就能进入对话界面:Mac-mini ~ % ollama run deepseek-r1:1.5b >>> Send a message (/? for help)

DeepSeek 本地运行使用演示

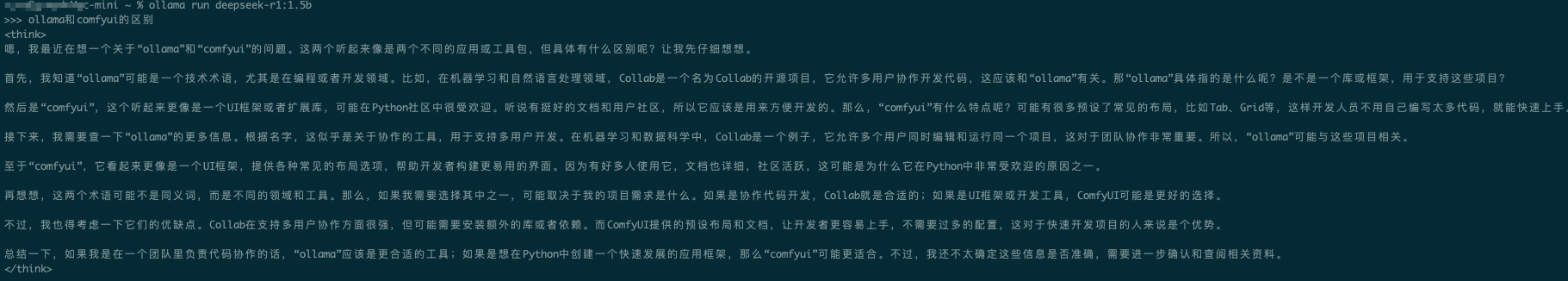

上面步骤搭建完成后,接下来提问DeepSeek一个问题:ollama和comfyui的区别?,下面是它的回答,首先会有一个think标签,这里面嵌入的是它的思考过程,不是正式的回复:

等我们看到另一个结束标签 think 后,表明它的思考已经结束,下面一行就是正式回答

Comments | NOTHING